Dynamiczny rozwój sztucznej inteligencji sprawił, że granica między rzeczywistością a obrazem wygenerowanym cyfrowo zaczyna się zacierać w tempie, którego jeszcze kilka lat temu trudno było się spodziewać. Pojawienie się rozwiązań umożliwiających generowanie wideo przez AI otworzyło zupełnie nowy etap w historii produkcji multimedialnej. W tym kontekście Sora 2 jawi się jako projekt szczególny — nie tylko jako kolejny generator wideo, lecz jako zapowiedź głębokiej transformacji sposobu, w jaki powstają współczesne treści wideo. Czy mamy do czynienia z przełomem, który realnie zmieni branżę kreatywną, marketing i edukację, czy raczej z kolejnym etapem ewolucji technologii?

Czym jest Sora 2 i na czym polega jej działanie?

Sora 2 to nowoczesny model sztucznej inteligencji stworzony przez OpenAI, który umożliwia tworzenie wideo na podstawie zwykłego opisu tekstowego. W praktyce wystarczy wpisać szczegółowy prompt, aby system wygenerował realistyczny materiał filmowy — bez kamery, ekipy zdjęciowej czy tradycyjnego montażu. Cały proces opiera się na tym, jak precyzyjnie opiszemy scenę, klimat i przebieg wydarzeń

Co istotne, rozwiązanie to nie ogranicza się do prostego animowania statycznych obrazów. Sora 2 potrafi odwzorowywać ruch, głębię przestrzeni oraz logiczne następstwo zdarzeń w obrębie sceny. Wygenerowany materiał stanowi spójną sekwencję, w której zachowana jest ciągłość narracyjna i rosnąca zgodność z zasadami fizyki.

Geneza powstania Sora 2 i rozwój technologii generatywnej

Aby zrozumieć znaczenie tej innowacji, należy osadzić ją w kontekście ewolucji systemów rozwijanych przez OpenAI. Początkowo rozwiązania te koncentrowały się na tekście – czego przykładem jest ChatGPT – następnie na obrazie, by ostatecznie umożliwić tworzenie ruchomych obrazów na podstawie komend. Każda kolejna wersja stanowiła odpowiedź na rosnące potrzeby rynku oraz oczekiwania odbiorców poszukujących bardziej zaawansowanych form ekspresji cyfrowej.

Jak działa model Sora 2 – podstawy technologiczne

Od strony technicznej Sora 2 opiera się na zaawansowanych algorytmach uczenia maszynowego, które zostały wytrenowane na ogromnej liczbie materiałów tekstowych i wizualnych. Dzięki temu system „rozumie”, jak powinny wyglądać obiekty, jak poruszają się w przestrzeni i jak zmieniają się w czasie. Wszystko zaczyna się od promptu, czyli opisu sceny wpisanego przez użytkownika. To właśnie ten opis jest dla modelu zestawem wskazówek, na podstawie których tworzy kolejne klatki i łączy je w spójną sekwencję wideo.

Jedną z kluczowych cech Sora 2 jest coraz lepsze odwzorowywanie zasad fizyki. Jeśli w opisie pojawia się na przykład spadający kubek albo rozwiewany przez wiatr płaszcz, system stara się oddać ich ruch w sposób naturalny i przekonujący. Dzięki temu sceny nie wyglądają jak przypadkowa animacja, lecz jak fragment rzeczywistości nagrany kamerą.

Co więcej, narzędzie potrafi uwzględniać zmiany perspektywy, ruch kamery czy interakcje między postaciami. Oznacza to, że użytkownik może stworzyć nie tylko prostą animację, ale bardziej rozbudowany materiał — na przykład klip promocyjny, krótką scenę filmową czy wideo do mediów społecznościowych.

Jakie możliwości oferuje Sora 2 w praktyce?

Możliwości Sora 2 obejmują zarówno krótkie formy przeznaczone do mediów społecznościowych, jak i bardziej rozbudowane sekwencje narracyjne. W kontekście marketingu czy komunikacji cyfrowej oznacza to zupełnie nowe podejście do produkcji treści – szybsze, bardziej elastyczne i oparte na technologii AI.

Generowanie realistycznych materiałów wideo z tekstu

Jedną z najważniejszych możliwości, jakie daje Sora 2, jest tworzenie wideo wyłącznie na podstawie tekstu. Użytkownik opisuje scenę — jej klimat, styl, tempo czy sposób kadrowania — a system zamienia ten opis w gotowy materiał filmowy. Co istotne, wygenerowane materiały nie są chaotycznym zbiorem animowanych klatek. Sora 2 dba o spójność przestrzeni i logiczny przebieg wydarzeń, dzięki czemu ruch postaci, światło czy relacje między obiektami wyglądają naturalnie.

Tworzenie animacji, symulacji i scen narracyjnych

Sora 2 nie ogranicza się jedynie do generowania pojedynczych klipów. Narzędzie pozwala tworzyć animacje oraz bardziej rozbudowane sceny, które mają własną logikę i ciąg zdarzeń. Oznacza to, że system potrafi nie tylko pokazać ruch, ale także „opowiedzieć” krótką historię — z początkiem, rozwinięciem i wyraźną dynamiką. W praktyce umożliwia to przygotowanie scen dialogowych, krótkich form fabularnych czy materiałów przypominających fragmenty filmu. Dla twórców internetowych, edukatorów czy zespołów kreatywnych w firmach to realna szansa na szybsze testowanie pomysłów i budowanie atrakcyjnych wizualnie treści.

Edycja i modyfikacja istniejących materiałów wizualnych

Kolejnym obszarem zastosowania Sora 2 jest możliwość modyfikowania i przekształcania już istniejących materiałów wizualnych. Choć główną funkcją systemu jest generowanie wideo przez AI, to coraz częściej mówi się o potencjale w zakresie wspierania edycji wideo. Oznacza to, że model Sora 2 może nie tylko tworzyć nowe sceny, ale również adaptować, rozszerzać czy stylistycznie przekształcać wcześniej przygotowane materiały.

W praktyce może to obejmować zmianę tła, dodanie nowych elementów wizualnych, modyfikację klimatu sceny czy poprawę jakości obrazu. Tego rodzaju integracja znacząco upraszcza proces tworzenia, skracając czas potrzebny na przygotowanie gotowego materiału.

Jak zacząć korzystać z Sora 2? Praktyczne wskazówki

Rozpoczęcie pracy z Sora 2 nie wymaga specjalistycznej wiedzy technicznej, ale dobre efekty nie pojawiają się przypadkiem. Kluczowe jest zrozumienie, jak system interpretuje opis i przekłada go na obraz w ruchu. To nie jest narzędzie typu „wpisz jedno zdanie i gotowe”, lecz rozwiązanie, które wymaga świadomego prowadzenia. Im precyzyjniejszy opis sceny, tym większa kontrola nad końcowym rezultatem.

Dostęp do narzędzia i wymagania techniczne

Dostęp do Sora 2 jest możliwy wyłącznie po wykupieniu subskrypcji ChatGPT Plus lub Pro (wyższa jakość i dłuższe wideo). Od stycznia 2026 całkowicie wyłączono darmowe generowanie wideo. Generowanie odbywa się w chmurze OpenAI, więc nie jest potrzebny mocny komputer – wystarczy stabilne połączenie internetowe.

Tworzenie skutecznych promptów

Sercem pracy z narzędziem takim jak Sora 2 jest umiejętność formułowania promptów, czyli opisów tekstowych, na podstawie których model AI do generowania wideo tworzy gotowy materiał. W praktyce to właśnie jakość polecenia decyduje o tym, czy uda się wygenerować realistyczne wideo, czy też efekt będzie odbiegał od oczekiwań. Im bardziej precyzyjny opis – obejmujący kontekst, styl wizualny, dynamikę kamery, atmosferę czy elementy scenografii – tym większa szansa na satysfakcjonujący rezultat.

Warto pamiętać, że generowanie wideo z tekstu to proces interpretacyjny. Model AI analizuje znaczenie słów, zależności między obiektami oraz potencjalną logikę zdarzeń. Jeśli opis jest zbyt ogólny, efekt może być przypadkowy lub uproszczony. Z kolei zbyt skomplikowane polecenie, zawierające sprzeczne informacje, może wprowadzić algorytm w błąd. Dlatego skuteczne korzystanie z Sora 2 polega na równowadze między szczegółowością a klarownością przekazu.

W praktyce pomocne jest testowanie różnych wariantów. Użytkownik może iteracyjnie modyfikować prompt, obserwując, jak zmienia się efekt końcowy. To podejście przypomina dialog z technologią – każda kolejna wersja polecenia pozwala lepiej zrozumieć, w jaki sposób model Sora 2 interpretuje określone pojęcia i buduje wizualną narrację.

Przykład promptu:

Create a 35-second cinematic video set in a near-future city powered by clean energy. The scene begins at sunrise with a wide aerial drone shot revealing modern glass skyscrapers covered in vertical gardens. Soft morning fog moves naturally between buildings, following realistic air flow and physics.

The camera slowly descends to street level, transitioning smoothly into a steady tracking shot of a young woman in her early 30s walking confidently toward a transparent electric tram. Her coat moves naturally in the wind, obeying real-world physics. Reflections in the glass surfaces should be accurate and dynamic.

As she enters the tram, the camera shifts to an interior close-up shot. Natural lighting from large panoramic windows illuminates her face. Subtle depth of field. Background passengers are engaged in quiet conversation, natural body language, realistic gestures.

Cut to a side view of the tram moving through the city. Motion blur should be physically accurate. Vehicles and pedestrians behave according to real-world physics and traffic logic.

Mood: optimistic, inspiring, premium technology commercial style. Ultra-realistic textures, high dynamic range, cinematic color grading similar to a high-end Apple or Tesla advertisement.

No subtitles. No logos. Focus on realism, smooth transitions, and consistent character appearance throughout the video.

Najczęstsze błędy początkujących użytkowników

Osoby rozpoczynające pracę często oczekują natychmiastowych, perfekcyjnych rezultatów. Tymczasem nawet zaawansowany model AI wymaga odpowiedniego prowadzenia. Jednym z najczęstszych błędów jest zbyt ogólne formułowanie poleceń, na przykład ograniczające się do krótkiego zdania bez określenia stylu, perspektywy czy charakteru sceny. W efekcie wideo może być poprawne technicznie, lecz pozbawione wyrazistości.

Przykład złego promta:

Make a cool video about the future with a woman in a city. Make it realistic and cinematic.

Na pierwszy rzut oka polecenie wydaje się poprawne — określa temat (przyszłość, kobieta, miasto) oraz sugeruje klimat (realistyczny, filmowy). Jednak z perspektywy działania modelu AI do generowania wideo jest ono zbyt ogólne i nieprecyzyjne.

Innym problemem bywa brak świadomości ograniczeń technologicznych. Choć Sora 2 lepiej przestrzega praw fizyki niż wcześniejsze rozwiązania, wciąż mogą wystąpić drobne niespójności w ruchu czy detalach. Oczekiwanie pełnej perfekcji na poziomie wysokobudżetowej produkcji filmowej może prowadzić do rozczarowania. Warto traktować model AI do generowania wideo jako narzędzie wspierające kreatywność, a nie całkowity substytut tradycyjnej produkcji.

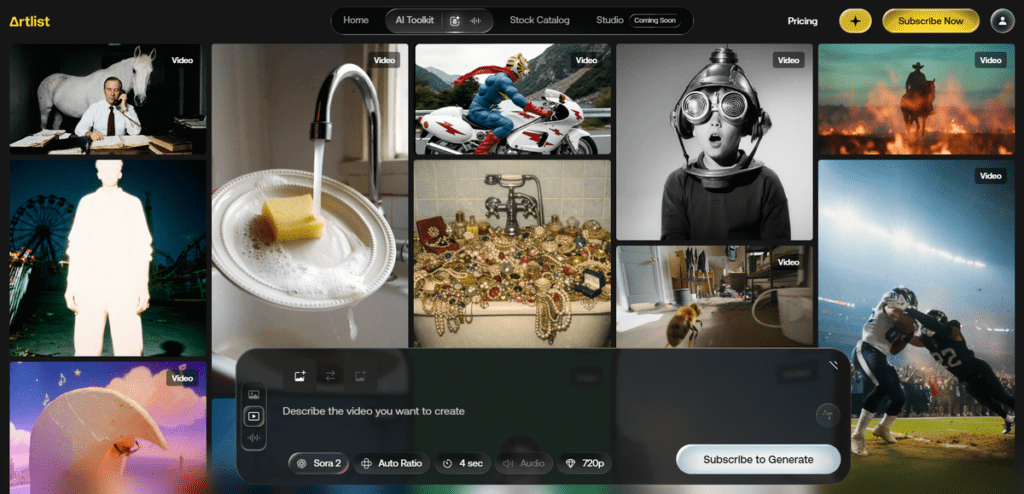

Sora 2 a inne generatory wideo AI – kluczowe różnice i podobieństwa

Rynek narzędzi do generowania wideo przez AI rozwija się niezwykle dynamicznie, a kolejne platformy prześcigają się w jakości, szybkości i możliwościach personalizacji. W tym kontekście Sora 2 nie funkcjonuje w próżni — musi być oceniana na tle konkurencyjnych rozwiązań, takich jak Runway Gen-3, Pika Labs czy Stable Video Diffusion. Każdy z tych systemów to inny model AI do generowania wideo, oparty na odmiennych założeniach technologicznych i skierowany do nieco innego typu użytkownika.

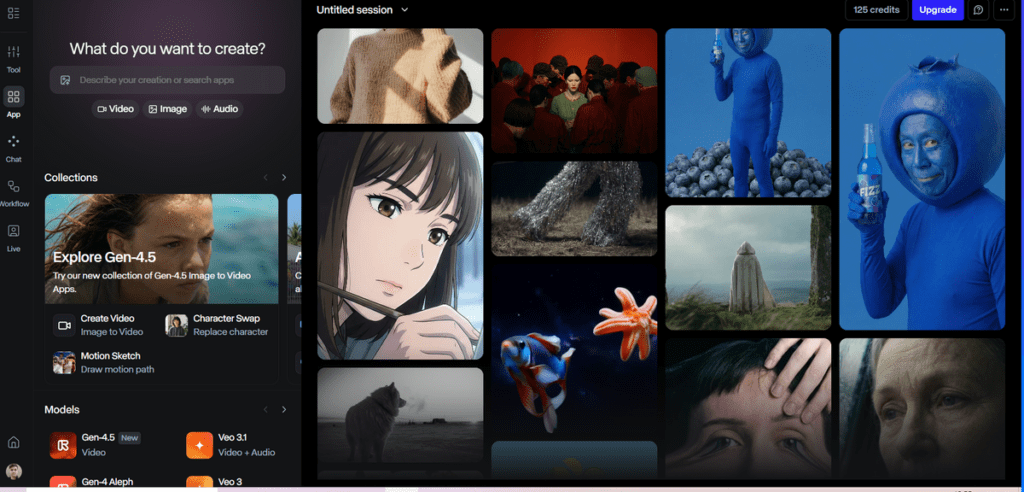

Sora 2 vs Runway – jakość, realizm i kontrola nad sceną

Runway to jedno z najbardziej znanych narzędzi do tworzenia wideo przy użyciu AI, szczególnie popularne wśród twórców cyfrowych i zespołów kreatywnych. Jego dużą zaletą jest rozbudowany interfejs przypominający klasyczne programy do montażu, co daje użytkownikowi sporą kontrolę nad ujęciami, przejściami czy efektami wizualnymi. To rozwiązanie dobrze odnajduje się w środowisku, w którym ważna jest możliwość ręcznej ingerencji i dopracowywania detali na poziomie edycji.

Sora 2 podchodzi do tematu nieco inaczej. Zamiast skupiać się na rozbudowanym panelu montażowym, większy nacisk kładzie na precyzyjne rozumienie opisu tekstowego i przekładanie go na spójną wizję wizualną. Jej siłą jest integracja modelu językowego z generowaniem obrazu w ruchu, co pozwala tworzyć bardziej złożone sceny bez konieczności ręcznego ustawiania wielu parametrów.

Oba narzędzia oferują wysoki poziom jakości, jednak różnią się filozofią pracy. Runway daje większą kontrolę w tradycyjnym rozumieniu montażu, natomiast Sora 2 stawia na inteligentne przetwarzanie opisu i coraz bardziej naturalne odwzorowanie ruchu oraz przestrzeni. Wybór między nimi zależy więc od tego, czy użytkownik preferuje klasyczne środowisko edycyjne, czy model pracy oparty głównie na dobrze zaprojektowanym prompcie.

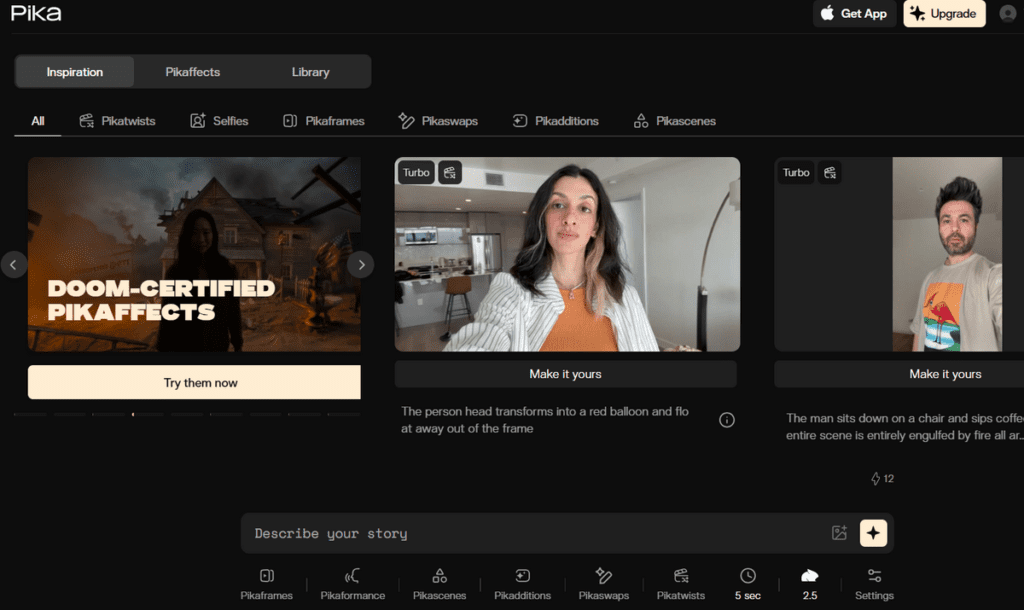

Sora 2 vs Pika Labs – elastyczność i szybkość generowania

Pika Labs zyskała popularność przede wszystkim dzięki prostocie obsługi i szybkiemu generowaniu krótkich materiałów wideo. To narzędzie dobrze sprawdza się przy tworzeniu dynamicznych klipów do mediów społecznościowych, gdzie liczy się czas realizacji i łatwość eksperymentowania z formą. Użytkownik może w kilka chwil wygenerować efektowną animację bez zagłębiania się w złożone ustawienia.

Sora 2 to rozwiązanie bardziej rozbudowane, nastawione na tworzenie scen o większej spójności i głębi. Zamiast skupiać się wyłącznie na szybkim efekcie, system dąży do budowania realistycznej przestrzeni, naturalnego ruchu kamery oraz logicznego przebiegu zdarzeń. W praktyce oznacza to większe możliwości przy projektach wymagających dopracowanej narracji i wyższego poziomu realizmu.

Sora 2 vs Stable Video Diffusion – otwartość technologii i możliwości integracji

Stable Video Diffusion wyróżnia się podejściem bardziej otwartym i technicznym. To rozwiązanie, które może być wdrażane lokalnie i modyfikowane przez społeczność, co daje większą kontrolę nad infrastrukturą i sposobem działania modelu. W przeciwieństwie do tego Sora funkcjonuje jako rozwiązanie rozwijane centralnie przez OpenAI, co oznacza większą kontrolę jakości, ale mniejszą swobodę ingerencji w sam model AI.

Dla firm technologicznych i zespołów programistycznych Stable Video Diffusion może być atrakcyjny ze względu na możliwość integracji z własnymi systemami. Wybór między tymi rozwiązaniami zależy więc od priorytetów: czy ważniejsza jest otwartość i możliwość modyfikacji, czy jakość i wsparcie dostawcy technologii.

| Narzędzie | Główne zastosowanie | Poziom realizmu | Kontrola nad sceną | Otwartość technologii | Dla kogo najlepsze? |

|---|---|---|---|---|---|

| Sora 2 (OpenAI) | Zaawansowane generowanie wideo z tekstu, sceny narracyjne, symulacja fizyki | Bardzo wysoki – nacisk na spójność ruchu i zgodność z prawami fizyki | Wysoka (rozbudowane prompty, narracja, kontrola stylu) | Model zamknięty rozwijany przez OpenAI | Marketing premium, edukacja, produkcje kreatywne |

| Runway | Generowanie i edycja wideo AI, praca w środowisku kreatywnym | Wysoki | Bardzo wysoka (interfejs, narzędzia montażowe) | Platforma komercyjna | Agencje, montażyści, twórcy wideo |

| Pika Labs | Krótkie klipy do social media, szybkie animacje | Średni–wysoki | Średnia | Platforma komercyjna | Content creatorzy, TikTok, szybkie kampanie |

| Stable Video Diffusion | Open-source model do generowania wideo | Zależny od konfiguracji | Wysoka (dla użytkowników technicznych) | Otwarte rozwiązanie | Developerzy, zespoły IT, integracje własne |

Przyszłość Sora 2 i rozwój generatywnego wideo AI

Rozwój Sora 2 pokazuje, że tworzenie materiałów filmowych przy użyciu sztucznej inteligencji przestaje być eksperymentem, a staje się realnym narzędziem pracy dla branży kreatywnej, marketingu i edukacji. Jeśli tempo innowacji zostanie utrzymane, systemy tego typu będą coraz precyzyjniej odwzorowywać ruch, emocje oraz relacje przestrzenne, minimalizując błędy i zwiększając realizm scen.

Kolejnym etapem może być pełna integracja obrazu, narracji i dźwięku w jednym środowisku. Wówczas narzędzie nie tylko przyspieszy produkcję, lecz także zmieni sposób myślenia o procesie twórczym — od koncepcji aż po gotowy materiał wideo.

Najczęściej zadawane pytania dotyczące Sora 2

Czy Sora 2 potrafi generować wideo z dźwiękiem i dialogami?

Obecnie Sora 2 koncentruje się głównie na generowaniu wideo z tekstu, jednak rozwój technologii zmierza w kierunku integracji obrazu i audio. W przyszłości możliwe może być pełne generowanie wideo i dźwięku, obejmujące dialogi oraz efekty dźwiękowe, co znacząco zwiększy realizm materiałów tworzonych przez model AI.

Czy Sora 2 jest darmowa?

Nie, Sora 2 nie jest darmowa. Od stycznia 2026 OpenAI całkowicie wyłączyło darmowy dostęp do generowania wideo. Narzędzie jest dostępne wyłącznie dla subskrybentów ChatGPT Plus lub wyższych planów (Pro). Aktualne warunki i limity znajdziesz zawsze na oficjalnej stronie openai.com lub sora.com.

Jakie są wymagania techniczne do korzystania z Sora 2?

Do korzystania z Sora 2 potrzebne jest stabilne połączenie z internetem oraz dostęp do platformy, na której narzędzie jest udostępnione (np. przeglądarka lub aplikacja). Sam proces generowania wideo AI odbywa się w chmurze, więc nie wymaga zaawansowanego sprzętu po stronie użytkownika.

Czy Sora 2 jest dostępna w Polsce?

Dostępność zależy od regionu i etapu wdrożenia. Często nowe rozwiązania najpierw pojawiają się w USA, a następnie w innych krajach. Informację o tym, czy Sora 2 jest dostępna w Polsce, najlepiej sprawdzić w oficjalnych komunikatach OpenAI.

Czy materiały wygenerowane przez Sora 2 można wykorzystywać komercyjnie?

Możliwość komercyjnego wykorzystania treści zależy od warunków licencyjnych określonych przez OpenAI. W przypadku zastosowań biznesowych – takich jak marketing czy kampanie reklamowe – warto zapoznać się z regulaminem, aby upewnić się, że wideo wygenerowane przez sztuczną inteligencję może być legalnie używane w celach komercyjnych.

Sprawdź również:

- Claude AI – funkcje i zastosowania

- TOP 7 najlepszych narzędzi AI do generowania wideo

- Poznaj narzędzie Midjourney – jak tworzyć grafiki z AI?

- Nano Banana – wszystko, co musisz wiedzieć o edytorze obrazów w Gemini